Cómo evaluar si la precisión de inspección de visión cumple con los requisitos

Queridos amigos, aquellos que se dedican a la fabricación y la automatización, ¡reúnanse! Hoy, hablemos de un tema crucial: ¿cómo determinar si la precisión visual cumple con el estándar? Aquellos involucrados en mediciones saben que la precisión es de suma importancia. Cuando usamos un sistema de visión para medir dimensiones, alguna variación es inevitable, y la diferencia radica en el número de decimales.

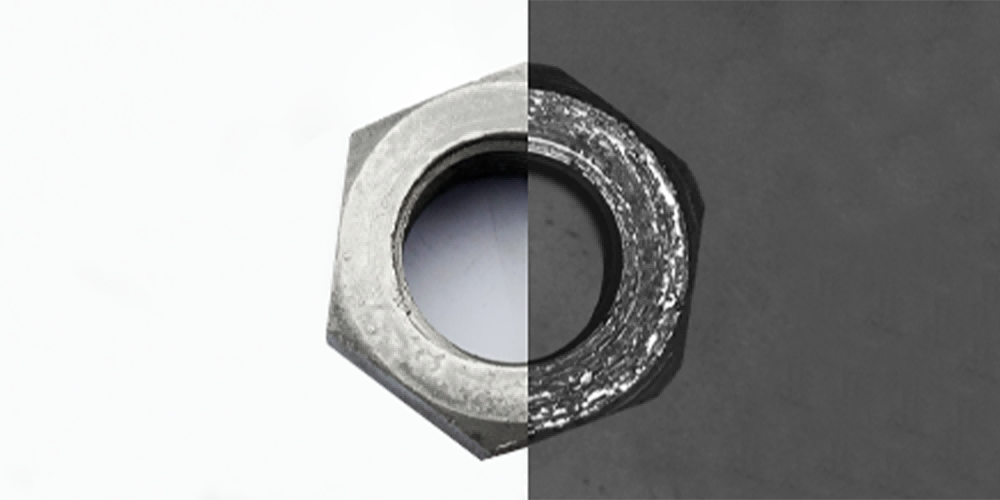

Por ejemplo, al medir el diámetro de un anillo, su tolerancia es de 0,1 mm. Según el estándar, la precisión de la herramienta de medición debe alcanzar 1/10 de la tolerancia, es decir, 0,01 mm. Pero, ¿qué significa exactamente esta precisión de 0,01 mm? No hay una conclusión unificada en la industria. Algunos creen que es la precisión de repetibilidad, mientras que otros dicen que es la precisión absoluta dentro del campo de visión.

Basándonos en nuestra experiencia, podríamos definirlo como la precisión de múltiples inspecciones de entrada del mismo producto. Tomemos como ejemplo el comúnmente visto equipo de clasificación óptica presente en el mercado. ¿Cómo determinamos su precisión de inspección para un producto? Coloque el producto repetidamente 30 veces y, después de la guía, la diferencia entre los valores máximos y mínimos obtenidos de la inspección es su precisión de inspección.

Sin embargo, muchos fabricantes consideran la variación dimensional del producto cuando está estacionario como la precisión, ¡lo cual es muy inexacto! ¡Debemos tener en cuenta el error de desviación del disco de vidrio, el error de guiado, y otros factores! Pero desafortunadamente, ya es bastante notable que el equipo óptico logre una precisión de 3 micras. Esto significa que desde una perspectiva rigurosa, solo podemos medir dimensiones con una tolerancia de 0,03 mm.

Pero en la producción real, hay muchos casos en los que es necesario medir dimensiones de 0,01 mm. Por lo tanto, muchos clientes también pueden aceptar herramientas de medición con una precisión de 1/3 o 1/5 de 0,01 mm. Después de todo, incluso al usar un micrómetro para la medición, inevitablemente habrá un error de unos pocos micrones.

Interpretación: (Precisión de Inspección) se refiere a la consistencia de los resultados de salida con la Verdad Terrenal cuando el sistema de visión por computadora, el equipo de inspección o el algoritmo identifica, clasifica o mide el objeto objetivo. Es el índice principal para medir la fiabilidad y efectividad del sistema de detección, y se utiliza ampliamente en la inspección de calidad industrial, la imagen médica, la conducción autónoma, la vigilancia de seguridad y otros campos.