Comment évaluer si la précision de l'inspection visuelle répond aux exigences

Chers amis, ceux qui travaillent dans la fabrication et l'automatisation, rassemblez-vous ! Aujourd'hui, parlons d'un sujet crucial : comment déterminer si la précision visuelle répond au standard ? Ceux qui sont impliqués dans les mesures savent que la précision est primordiale ! Lorsque nous utilisons un système de vision pour mesurer des dimensions, une certaine variation est inévitable, et la différence réside dans le nombre de décimales.

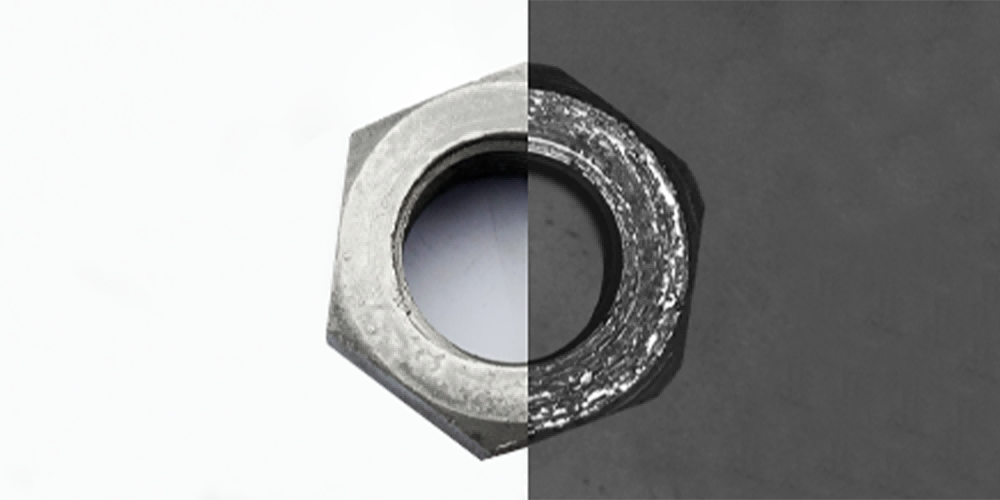

Par exemple, lors de la mesure du diamètre d'une bague, sa tolérance est de 0,1 mm. Selon la norme, la précision de l'outil de mesure doit atteindre 1/10 de la tolérance, c'est-à-dire 0,01 mm. Mais qu'en est-il exactement de cette précision de 0,01 mm ? Il n'y a pas de conclusion unifiée dans l'industrie. Certaines personnes pensent que c'est la précision de répétabilité, tandis que d'autres disent que c'est la précision absolue dans le champ de vision.

Sur la base de notre expérience, nous pourrions tout aussi bien le définir comme la précision de plusieurs inspections entrantes du même produit. Prenons l'exemple courant de la machine de tri optique présente sur le marché. Comment déterminons-nous sa précision d'inspection pour un produit ? Placez le produit 30 fois de suite et après guidage, la différence entre les valeurs maximales et minimales obtenues lors de l'inspection représente sa précision d'inspection.

Cependant, de nombreux fabricants considèrent la variation dimensionnelle du produit lorsqu'il est au repos comme étant la précision, ce qui est très inexact ! Nous devons prendre en compte l'erreur d'excentricité du disque en verre, l'erreur de guidage, et ainsi de suite ! Mais malheureusement, il est déjà assez remarquable que des équipements optiques atteignent une précision de 3 microns. Cela signifie qu'à un point de vue rigoureux, nous ne pouvons mesurer que des dimensions avec une tolérance de 0,03 mm.

Mais dans la production réelle, il existe de nombreux cas où il est nécessaire de mesurer des dimensions de 0,01 mm. Par conséquent, de nombreux clients acceptent également les outils de mesure avec une précision de 1/3 ou 1/5 de 0,01 mm. Après tout, même en utilisant un micromètre pour la mesure, il y aura inévitablement une erreur de quelques microns.

Interprétation : (Précision d'inspection) fait référence à la cohérence des résultats de sortie avec la Vérité Terrain lorsque le système de vision par ordinateur, l'équipement d'inspection ou l'algorithme identifient, classifient ou mesurent l'objet cible. C'est l'indice clé pour évaluer la fiabilité et l'efficacité du système de détection, et il est largement utilisé dans l'inspection de la qualité industrielle, l'imagerie médicale, la conduite autonome, la surveillance de sécurité et d'autres domaines.